En participant au concours de référencement zobibi, je me suis attaché à ne pas trop polluer la Home de ce blog en masquant les billets de la catégorie zobibi avec un position: absolute;left: -50000px pour les visiteurs équipés d’un navigateur moderne. Les robots des moteurs de recherche comme GoogleBot de Google ne tiennent pas (encore) compte des feuilles de styles CSS et indexent allègrement ce contenu masqué aux êtres humains.

Cette technique s’apparente à ce que l’on appelle communément le cloaking : servir aux moteurs de recherche un contenu différent de ce que voit l’internaute, que ce soit pour induire en erreur les robots ou les visiteurs.

Toutefois, les techniques basées sur les CSS n’empêchent nullement le contenu en question d’apparaitre dans le flux RSS et j’imagine que les quelques 750 abonnés de ce blog ne sont pas forcément intéressés par mes détournements musicaux…

Pour remédier à cela j’ai fait appel à Twitter Land où MrMoins de Canal Moins m’a rapidement proposé Ultimate Category Excluder qui permet d’exclure une catégorie spécifique du flux RSS. Hélas, chez moi, ce plugin ne fonctionne pas (j’ai transmis mon rapport de bug à l’auteur et je vous tiens au courant).

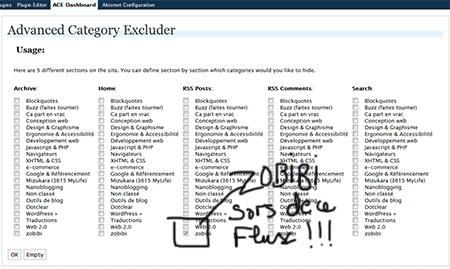

En effectuant des recherches complémentaires, je suis tombé sur le plugin Advanced Category Excluder qui fonctionne avec WordPress 2.3.2.

Ce plugin propose d’exclure une ou plusieurs catégories dans les sections Archives, Page d’accueil, Flux RSS des billets et/ou des commentaires et Recherche ce qui permet de mieux granulariser l’information publiée.

Salut 🙂

Je voulais savoir si tu utilisais les fonctions de cache ou des extensions pour améliorer la vitesse et la résistance a la charge de ton wordpress.

voila ^^

Sinon cette extension ma l’air pratique.

Moi, au contraire, je crois que Google sait parfaitement lire les feuille de style, justemment pour detecter des display:none abusif ou des couleurs de texte identique à la couleur de fond… Je suis avec attention ce qui va se passer pour ton positionnement sur zobibi (<- sympa hein !) et te souhaite bon courage.

Et le grand gagnant de la meilleure astuce est ………

Tu utilises feedburner … Je te conseille une autre façon de fonctionner alors !

Afin de ne pas surcharger ton wordpress avec un plugin totalement INUTILE, jete un oeil sur cette image …

http://tinyurl.com/35g2pg

Voila comme désactiver trèèès simplement des catégories 8)

Ohhhhh bien vu Alexis… +1 !!!

Pas de surcharge inutile de wordpress … pas de modification du code (et donc, pas de soucis lors de MAJ)… puis c’est on ne peut plus simple. :p

Yep, c’est vraiment une solution à la fois élégante et toute bête que tu nous as dégotté là… Bravo ! 😀

@Tix > je n’utilise pas de système de cache pour optimiser la résistance à la charge car pour l’instant je n’en ai pas vraiment besoin, mais qui sait lorsque ce blog aura plus de 3000 visites / jours on ne sait jamais 😉

@Clem > il semble que dans certains cas google pénaliserait l’utilisation du display:none http://ocarbone.free.fr/?p=223 notons que dans ce cas il s’agit d’un style en ligne.

Après faut prendre en compte que Google peut avoir la capacité de « voir » les display:none sans pour autant les prendre en compte systématiquement (en pénalisant les sites), vu qu’il s’agit d’une technique extrêmement courante.

@Alexis > alléluya, ton astuce est trop, mais alors trop top 🙂

@burningHat > je plussoie à ton plussoiement 😉

@Alexis > donc du coup, j’ai opté pour ton astuce même si cette méthode laisse le flux originel intact, ce qui peut avoir des inconvénients s’il est indexé automatiquement par des aggrégateurs ou si des visiteurs « historiques » n’ont pas fait la mise à jour vers le flux feedburner (je me suis rendu compte qu’il y en avait un certain nombre dans ce cas).

L’avantage est qu’on peut ainsi avoir deux flux pour deux types de visiteurs, ce qui peut être intéressant lorsqu’on veut élargir sa thématique sans pour autant « pénaliser » les lecteurs fidèles à la charte éditoriale précédente.

Oui, une utilisation avancée de ce type (flux différents et regroupement par thématique) est possible effectivement.

Sinon ce que je te conseille pour ton éventuel ancien flux, c’est d’utiliser FeedSmith pour bien rediriger ton feed wordpress vers feedburner. Ainsi tout le monde passera par ton feedburner 😉

@Alexis, j’ai installé feedsmith, mais ça n’a jamais marché chez moi, tu coup, j’ai supprimé le flux d’origine à la main et rajouté feedburner à la main aussi. Finalement, on peut se passer de quelques plugins assez facilement :p

Avec ta méthode on peut même créer un flux très spécifique à la main dans le header pour qu’il soit reconnu par les navigateurs, saicool 🙂

Je vais expliquer tout ça dans un article ce soir 🙂

@Alexis : Merci, du coup, hop ! un petit lien vers l’article en question : http://blog.alcd.be/262-gerer-les-categories-wordpress-dans-un-flux-rss-sans-plugin

Je pense que tu sous-estimes la puissance des moteurs de recherche en matière d’identification de cloaking. De plus, en particulier en te dénonçant ici, tu risques de te faire dénoncer par un petit camarade ou lecteur qui signalera ta technique à Google.

Allez, un peu de lecture chez Matt Cutts (responsable de l’équipe anti-spam chez Google) concernant le « undetectable cloaking » :

http://www.mattcutts.com/detecting-more-undetectable-webspam/

ou encore cet article sur les liens cachés :

http://www.mattcutts.com/hidden-links/

car je devine que tout comme pour le CSS, tu penses que les moteurs de recherche n’interprètent pas le JavaScript…

@Martin > Je n’ai pas dit que les moteurs n’interprêtaient pas le javascript ou les css, mais je pense qu’ils n’en tiennent pas compte lors de l’indexation des pages.

Quand au risque de dénonciation, ma foi, comme on dit « no pain no gain » 😉

De plus, et c’est peut-être là le plus important : Google sanctionne surtout ce qu’il appelle le « deceptive cloaking », à savoir, en anglais dans le texte : « it means that a webserver is returning different content to Googlebot than to users ».

Ici, le serveur sert exactement le même contenu aux visiteurs qu’aux moteurs de recherche. 🙂

En revanche, il ne faudrait pas que Google se mette de son côté à employer des méthodes proches du hacking pour remonter à la source de « deceptive content » ce qui serait assez mal venu de la part du champion de démocratie, non ?

@Bruno, Google considère qu’utiliser des limites des moteurs de recherche pour présenter un contenu distinct au moteur de recherche des utilisateurs humains est du « deceptive cloaking », y compris en usant des CSS et du JavaScript. Je t’invite à te souvenir de l’affaire BMW :

http://www.mattcutts.com/ramping-up-on-international-webspam/

où BMW.DE affichait exactement le même contenu pour tous : une page web bourrée de mots-clés à destination des moteurs de recherche, à ceci près que les utilisateurs humains qui avaient le JavaScript activé étaient redirrigés, via ce JavaScript, sur une autre page.

Avec ton astuce de CSS, tu fais exactement du « deceptive cloaking », à savoir qu’en dehors des moteurs de recherche, personne ne lira le contenu ainsi caché aux visiteurs humains. Fais donc attention à ne pas tout simplement te faire déréférencer de Google, car autant ce type de sanctions est rare, autant il peut faire mal quand il arrive…

Pour ce qui est de la démocratie, il me semble que Google (via Matt Cutts du moins sur son blog personnel, cela n’engage en réalité que lui, certes) insiste bien sur le fait que tu as le droit de faire ce que tu veux sur ton site… tout comme eux ont le droit de faire ce qu’ils veulent avec ler index. 😛

@Martin > oui je me souviens de l’affaire BMW. L’idée derrière de Deceptive cloaking c’est que l’internaute qui aura saisi un mot-clé arriverait sur une page qui ne correspond pas à ses attentes.

Dans le cas d’un concours de référencement, vu que les mots-clés sont choisi pour leur total manque de sémantique, il me parait difficile pour un visiteur saisissant « zobibi » dans Google d’être « déçu » par les résultats retournés 😉

Contrairement à BMW, il n’y a pas ici de volonté de tromper qui que se soit.

Bon, après, je joue un peu sur les mots et les limites de ce que je perçoit comme acceptable de la part de Google, j’avoue ^_^v

Chez moi non plud « Ultimate Category Excluder » ne fonctionne pas je vais donc essayer ta deuxième solution.

Merci